3月4日,Intel已经将NPU加速库开源并放上GitHub,使得基于酷睿Ultra处理器的AI PC可以运行TinyLlama、Gemma-2b之类的轻量级大语言模型。

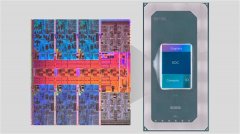

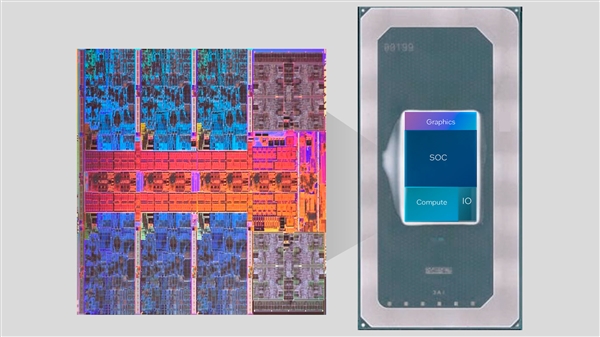

酷睿Ultra首次引入了NPU AI引擎,可以执行一些轻负载的AI推理任务,并与CPU、GPU搭配处理各种AI工作。

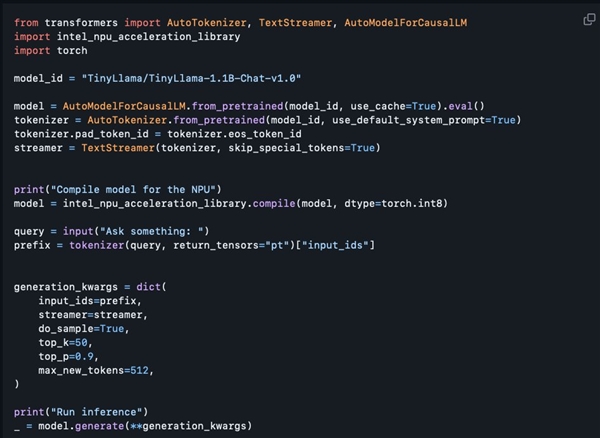

这次开源的NPU加速库,当然是面向开发人员的,但如果你有一定的编程经验,也可以拿来体验体验。

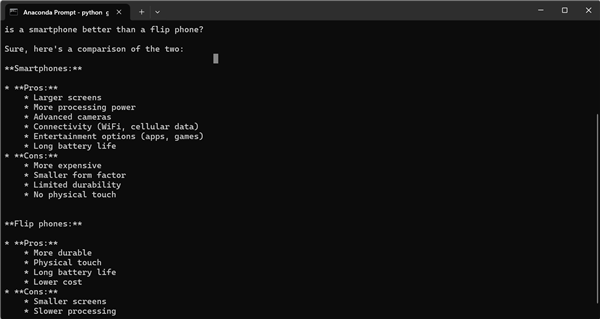

Intel软件架构师Tony Mongkolsmai展示了利用此开源的NPU加速库,在一台微星尊爵14 AI Evo笔记本上,基于11亿参数的TinyLlma大模型,运行了一个AI聊天机器人,可以进行简单对话。

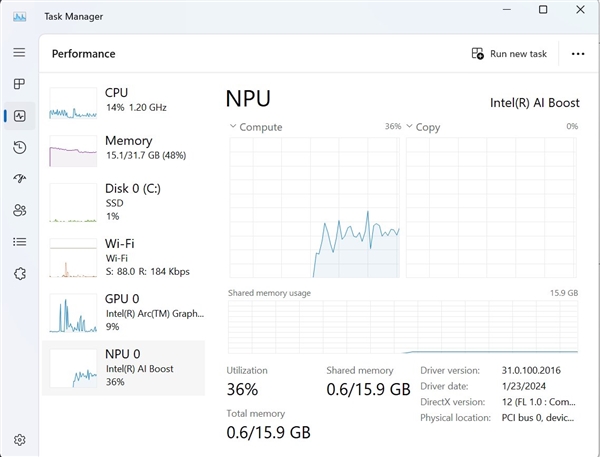

同时,Windows任务管理器显示,NPU确实被调动起来了。

不过,开源NPU加速库目前的功能还很残缺,支持了8比特量化、FP16精度,但还不支持4比特量化、BF16精度、NPU/GPU混合计算等等,技术文档也没有。

Intel承诺,后续会逐渐增加更多功能,比现在要多一倍。